发布时间:2026-01-26 来源:EETOP

微软正式推出全新自研人工智能加速器——Azure Maia 200,这款新一代自研 AI 芯片隶属于微软 Maia GPU 系列,是一款专为 AI 模型推理打造的服务器芯片,具备超高推理速度与数据吞吐能力,性能超越云服务巨头亚马逊和谷歌的同类型定制芯片。

Maia 200 被微软称为旗下迄今部署的能效最优的推理系统,其官方通稿中,一边高调公布该芯片的亮眼性能数据,一边着重强调微软对环保理念的践行。微软宣称,相较于初代产品 Maia 100,Maia 200 的每美元性能提升 30%;值得关注的是,这款新芯片的设计热功耗(TDP)相较前代实则提升了 50%,能实现这一性能突破,实属亮眼成就。

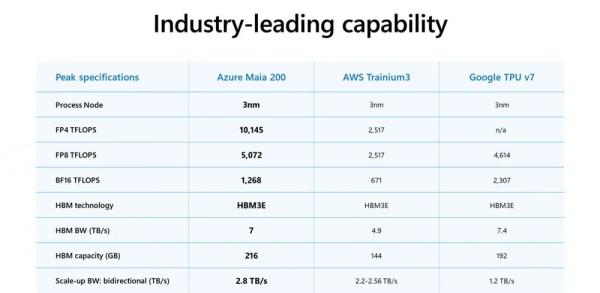

Maia 200 基于台积电 3 纳米制程工艺打造,集成1400 亿颗晶体管。微软方面表示,该芯片的 FP4 精度计算算力可达10 petaflops(千万亿次 / 秒),是亚马逊竞品 Trainium3 的三倍。此外,Maia 200 片上搭载 216GB 第三代增强型高带宽内存(HBM3e),内存带宽达 7TB / 秒,同时配备 272MB 片上静态随机存取存储器(SRAM)。

从硬件算力来看,Maia 200 相较于亚马逊的自研竞品优势显著,与英伟达旗舰 GPU 的对比也引发了行业热议。但显然,二者无法直接对标:Maia 200 不向外部客户直接销售;英伟达 Blackwell B300 Ultra 针对更高算力需求的应用场景优化,定位与这款微软芯片不同;且英伟达的软件生态体系,更是远超当下所有同类产品。

不过在能效表现上,Maia 200 完胜 Blackwell B300 Ultra—— 在公众对 AI 技术的环境影响质疑声日益高涨的当下,这一优势成为微软的重要亮点。Maia 200 的设计热功耗仅为 Blackwell B300 Ultra 的近一半(分别为 750 瓦和 1400 瓦);参考初代 Maia 100 的实际运行表现,Maia 200 的实际运行功耗或低于理论设计热功耗:Maia 100 的设计功耗为 700 瓦,而微软称其实际运行时被限制在 500 瓦。

Maia 200 针对 FP4 和 FP8 精度计算做了专项优化,核心服务于对 FP4 精度算力需求较高的 AI 模型推理客户,而非复杂的高精度计算场景。微软为该芯片投入的大量研发预算,主要用于优化其 272MB 高效 SRAM 构成的存储层级架构:该架构被划分为多层级集群级 SRAM(CSRAM)和瓦片级 SRAM(TSRAM),既能提升芯片运行效率,也能实现工作负载在所有高带宽内存(HBM)和静态随机存取存储器(SRAM)裸片上的智能、均匀分配。

目前难以精准衡量 Maia 200 相较前代 Maia 100 的具体提升幅度,原因在于微软公布的两款芯片官方参数表中,几乎无重叠的对比指标和统一的测算标准。现阶段可确定的是,Maia 200 的运行发热量高于 Maia 100,且每美元性能指标确有 30% 的提升。

Maia 200 已率先在微软美国中部区域的 Azure 数据中心完成部署,微软同时宣布,后续将在亚利桑那州菲尼克斯市的美国西部 3 区数据中心落地该芯片,随着芯片产能的提升,还将在更多数据中心部署。该芯片也将成为微软异构计算部署体系的重要组成部分,与其他不同类型的 AI 加速器协同运行。

Maia 200 的研发代号为 Braga,其研发与发布进程的大幅延期曾引发行业关注。这款芯片原定 2025 年完成发布与部署,甚至有望先于英伟达 Blackwell B300 Ultra 面市,最终却未能如期实现。据去年 10 月的相关报道,微软下一代硬件产品的制程工艺或将采用英特尔代工的 18A 工艺,不过目前其具体发布计划尚未确定。

微软围绕 Maia 200 打出 “能效优先” 的宣传牌,延续了其近期的发展基调:强调企业对数据中心周边社区发展的关注,竭力缓解市场对 AI 热潮的反对声浪。微软首席执行官萨提亚・纳德拉近期在世界经济论坛上表示,若企业无法让公众看到人工智能发展和数据中心建设带来的实际益处,就可能失去社会认可,甚至引发令人担忧的 AI 泡沫。