发布时间:2024-11-04 来源:半导体行业观察

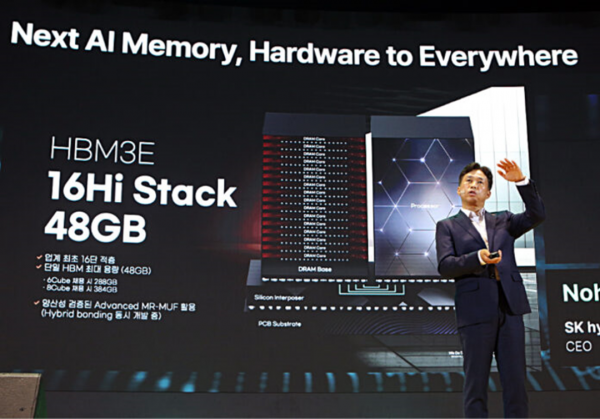

SK 海力士在其12-Hi HBM3e内存芯片上增加了四层,将容量从 36 GB 提高到 48 GB,并计划于 2025 年推出这款 16-Hi 产品的样品。

到目前为止,所有 HBM3e 芯片最多都有 12 层,据悉 16 层 HBM 将在未来一两年内与HBM4标准一起问世。SK 海力士首席执行官 Kwak Noh-Jung 在首尔 SK AI 峰会的主题演讲中透露了 16-Hi 技术。

高带宽内存(HBM) 堆叠内存芯片并通过插入器单元(而不是通过插槽系统)将它们连接到处理器,以此来增加内存到处理器的带宽。此标准的最新一代是扩展 HBM3 (HBM3e)。

即将推出的 HBM4 标准与 HBM3e 的不同之处在于,HBM4 预计每针 10 Gbps 以上,而 HBM3e 的最大速度为每针 9.2 Gbps。这意味着堆栈带宽约为 1.5 TBps,而 HBM3e 为 1.2 TBps 以上。HBM4 可能支持比 HBM3e 更高的容量,可能高达 64 GB,并且延迟也更低。据报道,Nvidia的 Jensen Huang 已要求 SK 海力士比计划提前 6 个月交付 HBM4 芯片。SK 集团董事长崔泰源表示,这些芯片将于 2025 年下半年交付。

根据 SK 海力士的内部测试,16-Hi HBM3e 芯片在 GenAI 训练中的性能提升了 18%,在推理中的性能提升了 32%,而 12-Hi 产品则没有如此大的提升。

SK hynix 的 16-Hi 产品采用 MR-MUF(大规模回流成型底部填充)技术制造。该技术结合了回流和成型工艺,通过熔化芯片之间的凸块将半导体芯片连接到电路上,并用一种称为液态环氧模塑料 (EMC) 的材料填充芯片之间的空间和凸块间隙。这提高了堆栈的耐用性和散热性。

SK 海力士首席执行官谈到了该公司的更多内存开发:

适用于 PC 的 LPCAMM2 模块基于 1c nm 的 LPDDR5 和 LPDDR6 内存PCIe 第六代 SSD大容量 QLC 企业级 SSDUFS 5.0 内存基片上带有逻辑处理的 HBM4 芯片用于外部存储器的 CXL 结构近内存处理 (PNM)、内存处理 (PIM) 和计算存储产品技术

所有这些都是 SK 海力士在面对 AI 工作负载对内存需求的持续大幅增长的情况下开发的。我们可以预期其竞争对手三星和美光也将开发类似容量的 HBM3e 技术。

SK海力士推出全球首款16层HBM3e

SK海力士于2017年11月推出全球首款16层HBM3E产品。4、展现其在高带宽内存(HBM)技术方面的领先地位。

SK 海力士首席执行官 Kwak Noh-jung 在首尔江南区 COEX 举行的 SK AI 峰会上发表主题演讲时推出了该产品。

今年2月,SK海力士在美国著名的国际固态电路会议(ISSCC)上发表了一篇关于16层HBM3E的论文,强调了该公司的前沿进展。上个月,它开始批量生产12层HBM3E产品,为推出更先进的16层版本奠定了基础。

Kwak强调了这一开发的重要性,他表示:“我们目前正在准备多种‘世界首创’的产品,这些产品是世界上首次开发和量产的。”他进一步阐述了公司的战略,并指出:“为了确保技术稳定性,为将随着下一代 HBM4 全面开放的 16 层产品市场做好准备,我们正在开发 48 GB 16 层产品HBM3E。”

16层HBM3E产品旨在满足高性能计算应用不断增长的需求,包括人工智能(AI)、图形处理和数据中心。SK Hynix 的内部分析显示,与 12 层产品相比,学习领域的性能提升了 18%,推理领域的性能提升了 32%。这一显着增强预计将推动新内存技术在各个行业的采用。

在12层产品中展现出量产竞争力的Advanced MR-MUF工艺将用于16层HBM3E的生产工艺。此外,SK海力士正在开发混合键合技术作为备用工艺,以确保新型存储芯片的可靠性和效率。

Kwak还宣布,SK海力士计划明年初向客户提供16层HBM3E样品。“我们计划明年初向客户提供样品,”他说,强调了公司致力于满足客户需求并加速新技术采用的承诺。

展望未来,SK海力士已经在研究未来的内存技术。Kwak透露,定制HBM4E的开发计划于2025年至2027年进行,定制HBM5和HBM5E的开发计划于2028年至2030年进行。“定制 HBM 通过反映各种客户需求(例如容量、带宽和附加功能)来优化性能,”他解释道。

除了 HBM 的进步之外,SK 海力士还在开发 LPCAMM2 模块、基于 1cnm 的 LPDDR5 和 LPDDR6、PCIe 第 6 代固态硬盘 (SSD)、基于大容量四级单元 (QLC) 的 eSSD 和 UFS 5.0 。这些开发针对未来的个人电脑、数据中心和其他高性能计算应用。

Kwak 表示:“我们正在开发 LPCAMM2 模块,预计以其低功耗和高性能的优势应用于未来的 PC 和数据中心,同时我们也在开发基于 1cnm 的 LPDDR5 和 LPDDR6。” “在 NAND 方面,我们正在准备 PCIe 第 6 代固态硬盘 (SSD)、基于大容量四级单元 (QLC) 的 eSSD 和 UFS 5.0。”

SK 总裁誓言与 Nvidia、台积电联手解决 AI 瓶颈问题

SK 集团董事长崔泰源再次致力于打造强大的人工智能生态系统,并誓言与人工智能先驱和关键合作伙伴 Nvidia 和台积电一起克服这一过程中的瓶颈。

崔泰源在周一于首尔举行的 SK AI Summit 2024 上列举了蓬勃发展的 AI 行业面临的诸多困难,并重申了他与 Nvidia 首席执行官黄仁勋、台积电首席执行官魏哲家和微软首席执行官萨蒂亚·纳德拉等科技界领袖的联系。在预先录制的视频中,首席执行官们发表了祝贺词,强调了 SK 海力士在其 AI 事业中发挥的作用。

“我上次与黄仁勋见面时,他问我能否比我们商定的日期提前六个月供应 HBM4,”崔泰源在首尔为期两天的活动开幕式上说道。“我问 SK 海力士 CEO 是否有可能,他说他会努力,所以我们正在努力将日期提前六个月。”

SK 集团的芯片制造子公司 SK 海力士在全球高带宽内存芯片市场占据主导地位,高带宽内存芯片是一种用于提升人工智能应用中图形处理单元性能的尖端组件。作为全球顶级 GPU 制造商 Nvidia 的主要 HBM 供应商,SK 海力士今年 7 月至 9 月的季度营业利润创下了 7.03 万亿韩元(51.3 亿美元)的纪录。

在一段预先录制的视频讲话中,Nvidia 首席执行官黄仁勋强调了 SK 海力士 HBM 芯片的重要性,称其为“超级摩尔定律”的推动者。摩尔定律指出,单个芯片上的晶体管数量每两年翻一番,通常用于描述芯片领域的快速进步。

“当我们从编码转向机器学习时,它极大地改变了计算机架构。我们在 HBM 内存方面所做的工作确实让我们能够实现看似超摩尔定律的目标,”黄仁勋在著名计算机科学家戴维·帕特森 (David Patterson) 的预录采访中说道。

“我们希望以更低的能耗获得更多的带宽。因此,SK Hynix 的路线图非常激进,而且非常必要。”

为了加强与全球科技巨头在人工智能领域的联系,崔泰源在 SK 集团内部成立了一个专门研究人工智能的工作组。

崔泰源随后强调了该集团与台积电的合作,台积电是全球最大的代工厂,生产 Nvidia 的尖端 GPU。台积电首席执行官魏哲家通过视频发表了祝贺词。

CC Wei 表示:“SK 海力士一直处于提供尖端 HBM 技术的前沿,其对创新的执着为塑造 AI 的未来做出了重大贡献。”

“高带宽、低功耗的内存解决方案已经改变了人工智能的工作负荷,突破了人工智能系统所能实现的界限。”

崔泰源将台积电描述为一家真正关心客户的公司,并回忆起他与台积电创始人张忠谋的对话,当时张忠谋支持他收购海力士的决定。SK 集团于 2012 年收购了内存芯片公司海力士。

“我认识张忠谋 20 年了。当我决定接管海力士时,我有机会和他交谈。他非常支持我,鼓励我说芯片行业前景光明,”崔泰源说。“他欢迎我加入这个行业,并一直作为宝贵的合作伙伴与我保持联系。”

在会上,SK集团董事长指出了AI持续增长需要解决的几个瓶颈:缺乏“杀手级用例”和收入模式来收回AI投资;AI加速器和半导体供应短缺;先进制造设施产能有限;确保AI基础设施有足够的能源面临挑战;以及对高质量数据的需求。

崔泰源强调,支持蓬勃发展的人工智能应用需要大量能源,同时还谈到了确保能源来源的必要性,并解释了 SK 对采用碳捕获技术的燃气轮机和小型模块化反应堆作为独立电源的投资。

在另一场会议上,SK 海力士首席执行官 Kwak Noh-jung 证实,该芯片制造商正准备大规模生产业界最新的 HBM 芯片,即容量为 48 GB 的 16 栈 HBM3E。

Kwak 表示,在模拟中,SK 海力士发现,与现有的 12 堆栈模型相比,其设想的 16 堆栈 HBM3E 芯片将使 AI 训练性能提高 18%,AI 推理能力提高 32%。

SK海力士凭借其HBM芯片在AI芯片市场上超越了其同城竞争对手三星电子。

当被问及 SK 海力士今年的年度收益是否可能首次超过三星时,SK 集团董事长谨慎地指出,不同公司对 AI 芯片的态度各不相同,而三星一旦乘上 AI 浪潮,将会“做得更好”。

崔泰源在开幕致辞后告诉记者:“三星拥有更多的技术和资源。我相信,借助人工智能的浪潮,三星将能够取得比现在更好的成绩。”

SK 海力士和三星争夺 Nvidia 内存芯片合同

Nvidia 依靠最新的高带宽内存 (HBM) 芯片来构建其最强大的图形处理单元 (GPU)。

随着近年来对 Nvidia GPU 的需求不断增加,其供应商也难以跟上步伐。

对于韩国内存芯片竞争对手SK 海力士和三星来说,Nvidia 的合同可以带来可观的收入,并有望实现未来增长。在争夺这些利润丰厚的交易时,两家公司都在竞相开发更好的 HBM 解决方案并扩大其制造能力。

尽管 Nvidia 仍在其较小的 GPU 上使用称为图形双倍数据速率 (GDDR) 的替代内存技术,但它更倾向于在 AI 训练中使用的重量级处理器上使用 HBM。

这两个芯片系列之间的一个关键区别是,GDDR 内存通常单独放置在 GPU 电路板上,而 HBM 可以放置在处理器旁边。靠近处理器使 HBM 具有其主要优势——速度。

随着 Nvidia 加速 GPU 开发,其内存需求也随之增加,该公司呼吁供应商改进其产品。

例如,据报道,首席执行官黄仁勋询问 SK 海力士将更先进的HBM4芯片的生产速度提前六个月。

据报道,SK Hynix 最初计划于 2026 年实现量产计划加快其 HBM 路线图,以便在 2025 年下半年推出首批芯片——正好赶上 Nvidia 预计推出的下一代 Rubin R100 GPU。

与此同时,三星也提前了其 HBM4 时间表,目标是在 2025 年底实现量产。

当 Nvidia 开始将 HBM 纳入其 GPU 设计时,它最初青睐的是 SK Hynix 芯片。媒体报道这表明,由于发热和功耗问题,三星芯片不符合 Nvidia 用于 AI 处理器的标准。

然而,据报道,今年 7 月 Nvidia批准三星的 HBM3 用于 H20 处理器,这是其旗舰产品 H200 的精简版,专为中国市场制造。

与三星合作可以帮助 Nvidia 解决供应链瓶颈,从而提高 GPU 产量。与此同时,三星投资者将扩大与 Nvidia 的合作关系视为潜在的摇钱树。

在最近的季度财报电话会议上,三星报告称,由于对人工智能基础设施的投资增加,HBM 的需求强劲。

该公司在一份声明中表示:“公司计划积极响应人工智能对高附加值产品的需求,并将扩大产能以增加 HBM3E 销售的份额。”